Appartient au dossier : Petite histoire du datajournalisme

Depuis les années 2000 : des journalistes codeurs ?

La principale révolution dans le datajournalisme apparaît dans les années 2000, avec la généralisation du Web et de l’Open data. De WikiLeaks à la crise du Covid, il s’est fait une place croissante dans les rédactions des plus grands journaux.

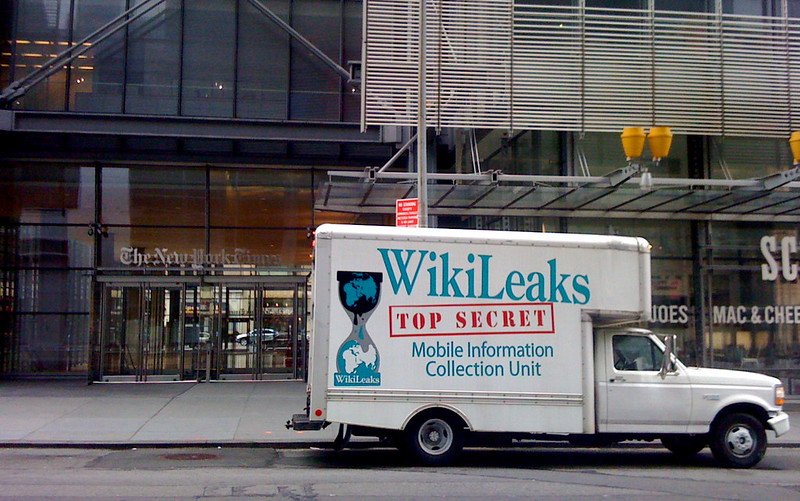

Le tournant WikiLeaks

Le site WikiLeaks est créé en 2006, dans le but d’offrir une plateforme aux lanceurs d’alerte en leur permettant de dévoiler des documents classifiés tout en protégeant leur anonymat, pour une plus grande transparence mondiale. L’ambition de Julian Assange, porte-parole de la plateforme, est d’en faire « l’organe de renseignements le plus puissant du monde », avec pour slogan « We open governments ». Dès 2007, plus d’une million de documents sont publiés sur WikiLeaks par des dissidents de nombreux pays.

En 2010, WikiLeaks rend public des centaines de milliers de documents confidentiels sur la présence militaire américaine en Afghanistan. Il s’allie rapidement à trois, puis cinq, grands organes de presse pour rendre visibles et intelligibles ces informations : The Guardian, The New York Times, Der Spiegel, El País et Le Monde. Ces médias traditionnels sont confrontés au dilemme inédit de publier des informations dont ils ne peuvent pas vérifier les sources. Ils bénéficient d’atouts qui manquent à WikiLeaks : les outils pour pouvoir traiter et recouper d’énormes quantités de données et la compétence de journalistes hackers, spécialistes de la donnée, ou spécialistes du thème ou de la région, capables par exemple de déchiffrer les abréviations militaires. Ils ont opéré des choix dans leur éditorialisation des informations, ce qui a mécontenté WikiLeaks, partisan d’une transparence totale.

L’arrivée de l’Open data

L’affaire WikiLeaks est symptomatique du mouvement de libération des données permis par le Web depuis les années deux mille dix. Les institutions publiques se sont engagées à diffuser les données publiques numériques de manière structurée et à garantir leur libre accès et leur réutilisation. En France, la mission Etalab lancée en 2011 a pour vocation de coordonner cette politique de la donnée ouverte, et le portail data.gouv.fr est lancé la même année.

Pour les journalistes, l’exploitation de l’Open data n’est plus une option, elle devient indispensable. À un contexte de rareté, nécessitant une investigation longue et laborieuse, succède une situation de surabondance de la donnée. La profession se structure alors, avec de nouvelles compétences autour de la maîtrise du code et l’émergence de nouveaux médias, à l’image d’Owni, site d’information spécialisé dans la culture numérique lancé en 2009 (fermé en 2012). Au sein des rédactions des médias traditionnels, des services de datavisualisation sont consacrés à la collecte, l’analyse et la mise en forme des données.

Quelques exemples de services de datavisualisation dans les grands médias traditionnels

Guardian data

Dès sa première édition en 1821, le Guardian exploitait des données pour les transformer en information. Le journal n’a pas rompu avec cette tradition et est aujourd’hui à la pointe de la datavisualisation, avec sa section Guardian data. En 2009, le Guardian va encore plus loin en lançant son Data Blog, coordonné par le journaliste Simon Rogers. Le journal rend accessibles les jeux de données exploités dans les articles du Guardian. En donnant accès à la matière statistique brute, sous forme de feuilles de calcul Google, il fournit un outil ouvert aux journalistes mais aussi aux chercheurs et aux citoyens. Selon Simon Rogers, « le datajournalisme n’est ni du graphisme, ni de la visualisation. Il s’agit de raconter une histoire de la meilleure manière possible. Parfois, c’est une visualisation ou une carte, parfois c’est un article. Parfois aussi, publier simplement un chiffre suffit […] C’est tout simplement du journalisme. »

Les Décodeurs du Monde

À l’origine, il s’agit d’un blog sur le site Web du Monde, créé en 2014 et dédié au fact checking participatif. Devenu une rubrique à part entière du Monde, il s’est redéfini autour de la vérification, la contextualisation et l’exploitation de la donnée. Constitué d’une équipe de « journalistes codeurs », les décodeurs prennent le parti de l’interactivité et de la visualisation pour rendre l’information plus accessible. Le code offre aux journalistes des moyens d’inventer, pour chaque sujet, une manière différente de le raconter. La majorité des productions des décodeurs s’appuie sur des données publiques. En 2019, l’équipe comptait treize personnes.

Le New York Times

Le New York Times compte également parmi les acteurs influents du datajournalisme. Le compte twitter nytgraphics rassemble les plus belles réalisations du journal en matière de visualisation de données et la page NYT Open regroupe des articles sur la manière dont le journal structure son rapport aux données. Il publie également des interviews de datajournalistes pour montrer comment le travail s’organise.

Publié le 02/08/2021 - CC BY-NC-SA 4.0

Les champs signalés avec une étoile (*) sont obligatoires